Jusqu’à présent acteur secondaire sur le marché de la mémoire vive à large bande-passante (HBM), Micron fait une percée sur ce terrain grâce à sa nouvelle mémoire HBM3E. Or, les dernières déclarations du groupe laissent entendre que l’approvisionnement en puces de ce type risque de se tarir à moyen terme. Une situation gênante, car elle pourrait induire un goulot d’étranglement potentiel dans la production de GPU dédiés notamment à l’intelligence artificielle, rapporte Tom’s Hardware.

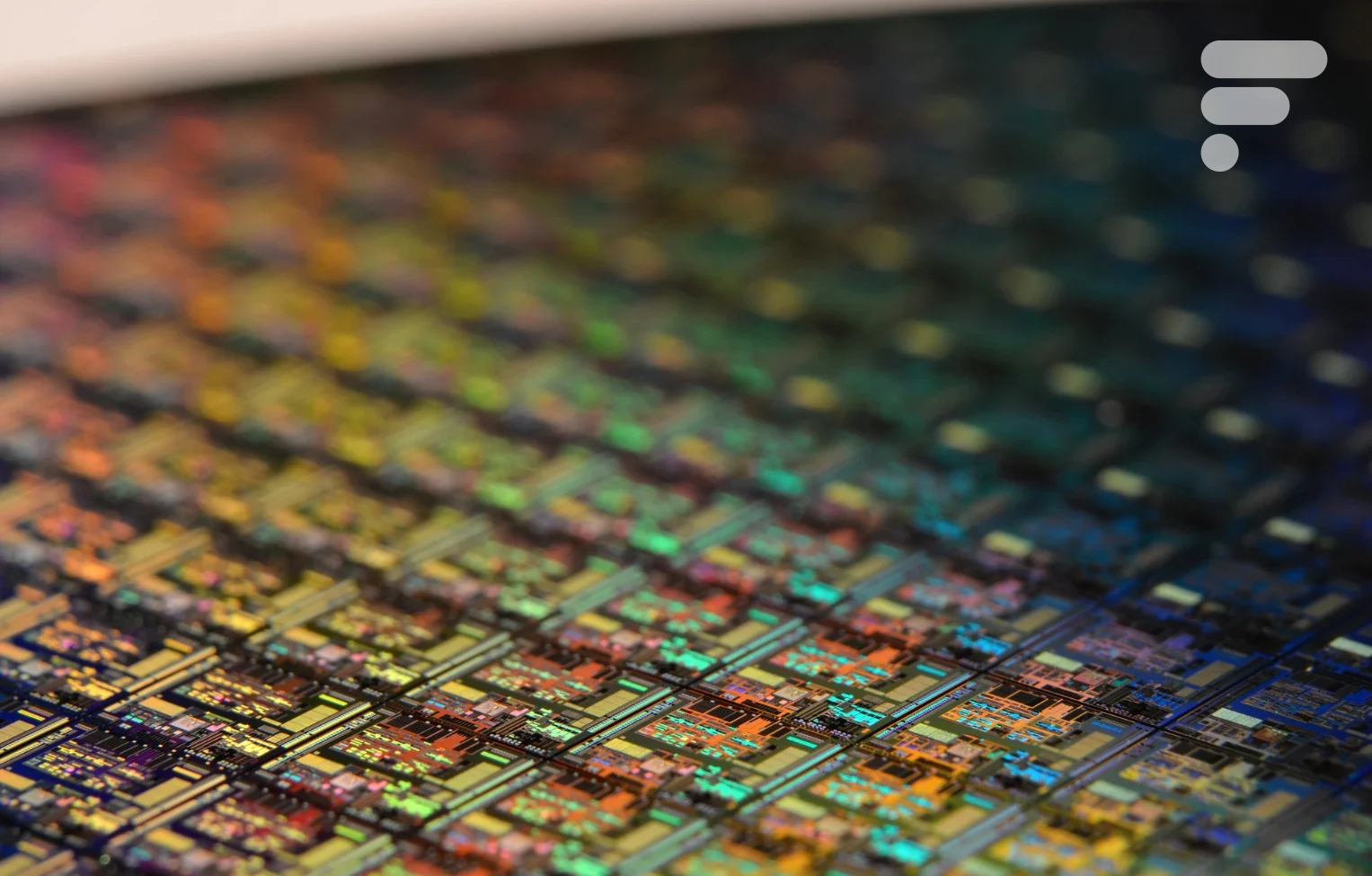

On apprend par ailleurs que la production à plein régime de mémoire HBM3E, très gourmande en wafers (ces galettes de silicium nécessaires à la fabrication des semi-conducteurs), pourrait aussi avoir des conséquences directes sur l’approvisionnement en mémoire DRAM, utilisée pour sa part sur de très nombreux appareils grand public. En d’autres termes, la piste d’une nouvelle pénurie de composants n’est pas à exclure — à l’instar de celle que l’on a connue après le Covid.

La mémoire HBM3E, critique pour Nvidia et ses GPU voués à l’IA

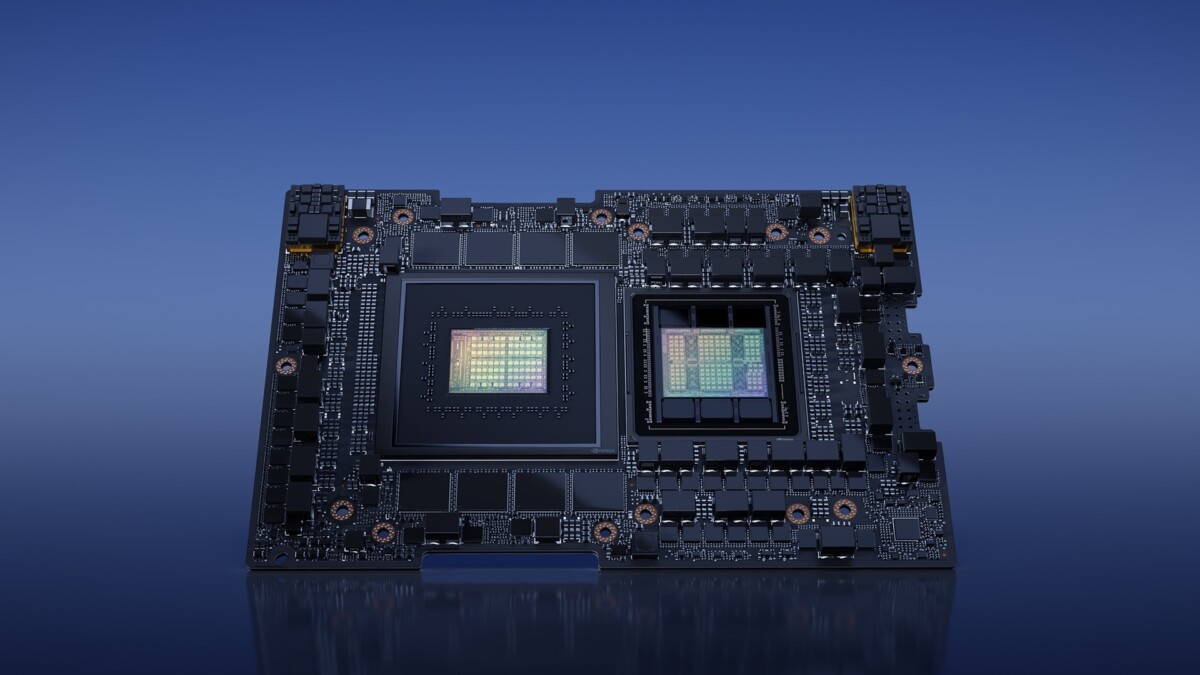

« Notre mémoire HBM est épuisée pour l’année 2024, et la grande majorité de notre offre pour 2025 a déjà été allouée », a notamment indiqué Sanjay Mehrotra, directeur général de Micron lors de l’annonce des derniers résultats du groupe, cette semaine. Pour contexte, la mémoire HBM3E de Micron (qui est la première entreprise au monde à exploiter commercialement ce type de mémoire vive), est notamment utilisée par le nouveau GPU H200 de Nvidia, voué à l’IA et aux supercalculateurs.

Pour la fabrication de chaque carte graphique H200, Nvidia utilise pas moins de six puces HBM3E, ce qui devrait permettre à Micron de s’accaparer une large part de marché sur le terrain de la mémoire HBM… au risque d’atteindre rapidement les limites de sa capacité de production, même si le groupe se veut rassurant.

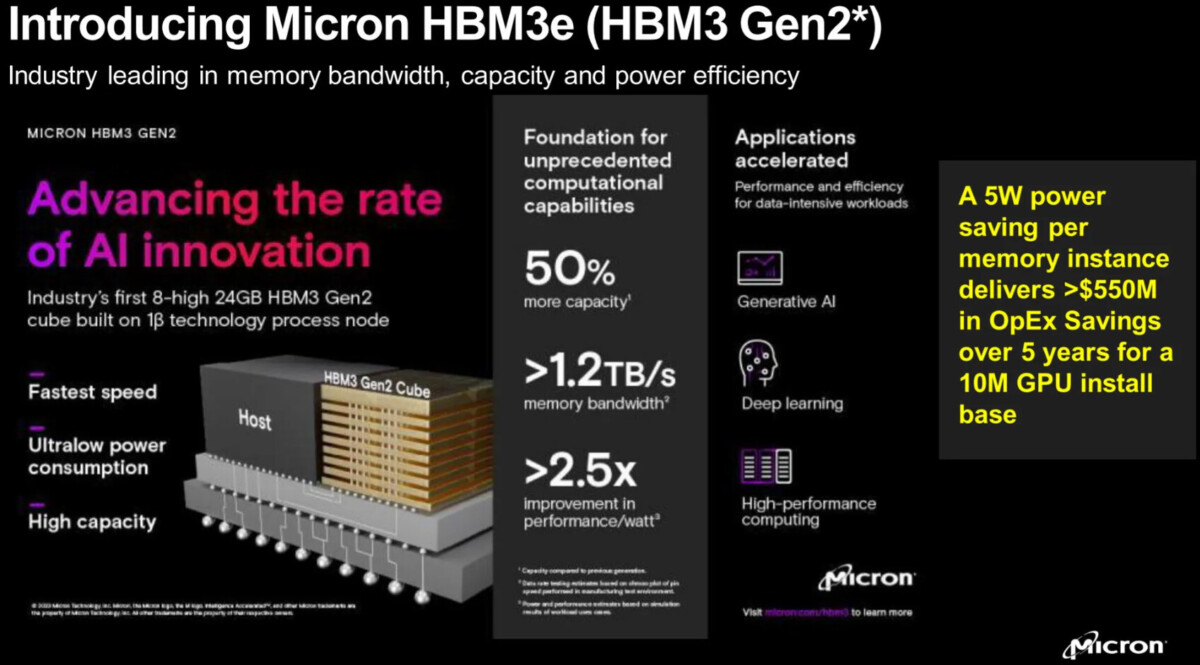

Sur le plan technique, les puces HBM3E de Micron sont actuellement des modules 8Hi de 24 Go, offrant un taux de transfert de données de 9,2 GT/s et une bande passante mémoire de plus de 1,2 To/s par dispositif. En utilisant six de ces puces par GPU H200, Nvidia lui permet ainsi de totaliser pas moins de 141 Go de mémoire HBM3E.

On sait néanmoins que Micron compte aller plus loin en la matière. Sa prochaine génération de puces mémoire HBM « 12Hi » devrait en effet permettre d’augmenter la capacité de 50 %, pour passer à 36 Go, et ainsi permettre à l’IA d’entraîner des modèles de langage toujours plus vastes.

Comme évoqué plus haut, cette course technologique et industrielle pour la mémoire HBM pourrait par contre induire des problèmes de production pour les modules DRAM plus classiques, employés à bien plus large échelle.

« Étant donné que la fabrication de modules HBM implique la production de DRAM spécialisée, la montée en puissance des puces HBM affectera considérablement la capacité de Micron à fabriquer des circuits intégrés DRAM pour les applications courantes », explique notamment Tom’s Hardware.

Un problème que Micron a d’ores et déjà admis. « La montée en puissance de la production d’HBM limitera la croissance de l’offre de produits non HBM », a en effet précisé Sanjay Mehrotra. « Dans l’ensemble de l’industrie, la mémoire HBM3E consomme environ trois fois plus de wafers que le standard DDR5 (…) ». Voilà qui est dit… et cela nous pousse à craindre d’éventuelles pénuries l’année prochaine.

Utilisez-vous Google News (Actualités en France) ? Vous pouvez suivre vos médias favoris. Suivez Frandroid sur Google News (et Numerama).

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix