Deux lettres sont sur toutes les lèvres depuis 2022 : IA. L’intelligence artificielle sort du carcan de la science-fiction pour devenir partie intégrante de nos vies dans des applications concrètes. Nos smartphones, ordinateurs, tablettes et mêmes consoles de jeux sont désormais équipés pour traiter des tâches de calculs liées à l’IA plus ou moins gourmande.

Des puces se sont notamment invitées dans nos PC portables, les NPU (Neural Processing Unit), des unités de calcul bien plus efficaces que votre processeur pour traiter les demandes de l’IA. On vous dit concrètement à quoi cela sert et pourquoi ils sont désormais au cœur de l’informatique grand public.

Une nouvelle puce dans nos ordinateurs

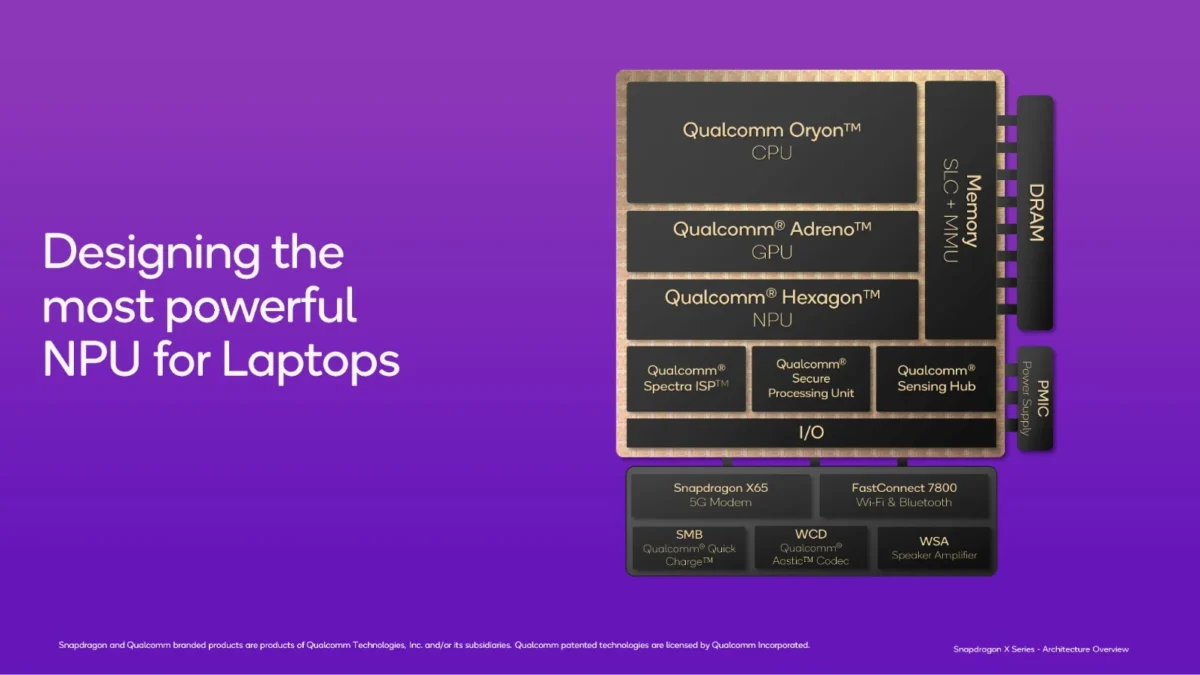

Avant de rentrer dans le vif du sujet, il s’agit de définir ce qu’est un SoC, dont le NPU, cette nouvelle puce, va faire partie intégrante. SoC, pour System-on-Chip, est un terme qu’on associe aux smartphones, tablettes et autres PC portables.

Au lieu de mettre plusieurs puces discrètes séparées sur un circuit imprimées comme par le passé, on intègre tout au niveau d’un seul circuit grâce à la miniaturisation : le processeur (CPU), la puce graphique (GPU), le modem, l’audio. Parfois, un SoC est aussi dédié à d’autres tâches comme le T2 d’Apple pour la sécurité au sein des ordinateurs Mac.

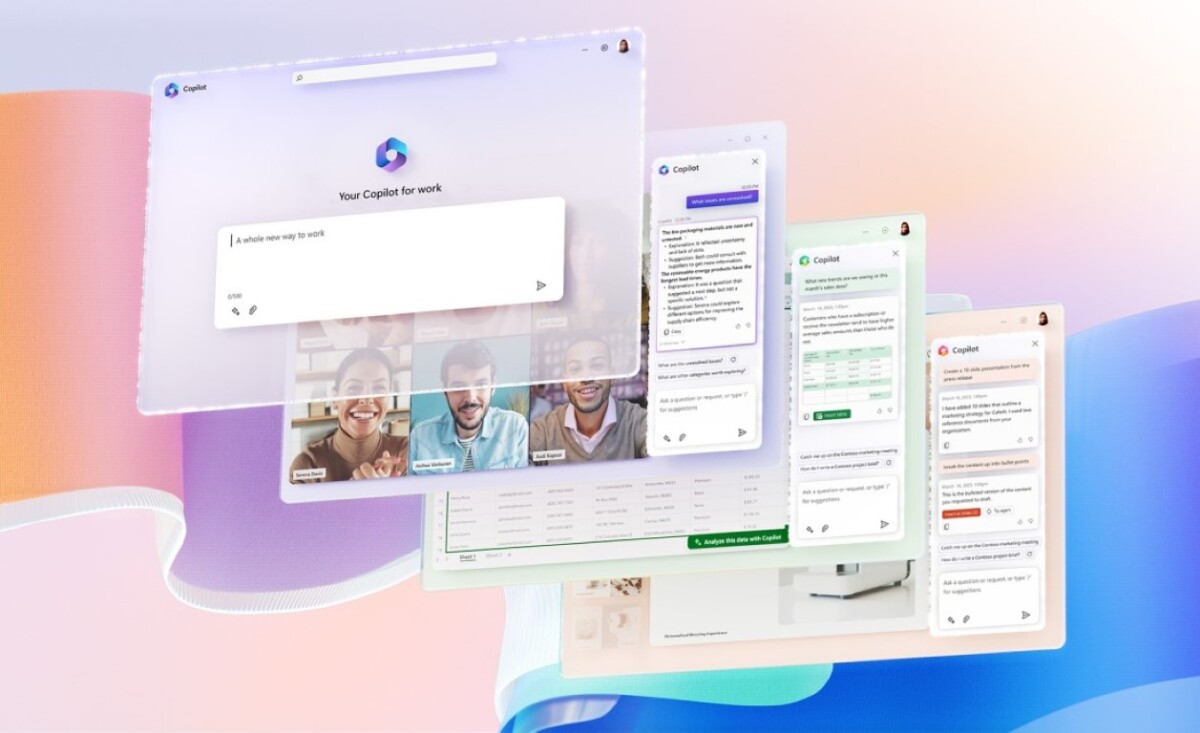

Mais ces SoC sont amenés à évoluer selon les usages et les technologies que les constructeurs veulent y intégrer. L’IA débarque sur nos smartphones, mais aussi nos PC portables et il devient nécessaire d’effectuer une partie de ces traitements directement sur l’appareil. On parle ici de faire tourner des modèles de langage naturel comme GPT à travers Copilot sur Windows, d’effectuer du traitement ou même de la génération d’image ou encore des sous-titres automatiques et diverses fonctionnalités d’accessibilité.

Quel est l’intérêt d’un NPU ?

Découvrez les PC les plus rapides et optimisés pour l’IA. Les adhérents Fnac+ peuvent bénéficier de jusqu’à 250 euros de remise.

Au fur et à mesure, ces charges de travail liées à l’IA et au machine learning ont pu en partie fonctionner en local, on device, grâce à l’intégration de puce dédiée, des NPU, pour Neural Processing Unit. Chez Appel on appelle ça le Neural Engine, et chez Google on appelle ça les Tensor Processing Unit pour TPU, mais le but est le même : accélérer les charges de travail liées à l’IA.

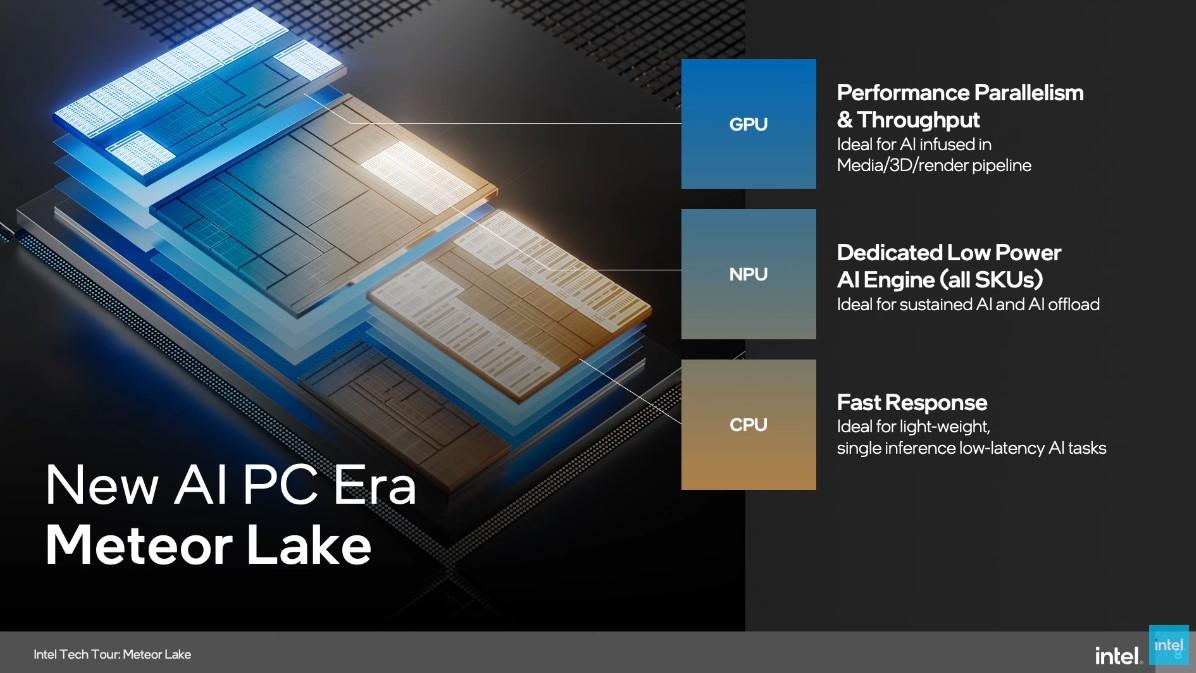

Votre processeur et votre carte graphique sont capables d’effectuer du machine learning, mais ont leur force et leur faiblesse à cet égard. Un NPU est dédié à la simulation d’une quantité massive de données en parallèle, pour imiter le fonctionnement des réseaux neuronaux, qui effectuent des millions de fois la même opération (matricielles ou vectorielles), mais avec des paramètres différents.

Le CPU peut lui se concentrer sur une seule tâche d’inférence, mais à une très faible latence alors que le GPU lui, grâce à des puces accélératrices IA (notamment les Tensor Cores des cartes graphiques Nvidia RTX), peut aussi traiter une quantité massive de données en parallèle, mais pour une consommation énergétique bien supérieure. Le NPU reste encore très en retard par rapport aux GPU pour les gros travaux d’inférence, comme faire fonctionner un véritable LLM en local ou effectuer de la génération d’images avancée, et ce à cause de l’énorme différence en termes de TOPS et de précision de calcul.

La puissance brute d’un NPU se calcule en TOPS, pour Trillions of Operations per Second, similaire aux TFLOPS pour les GPU. Ainsi, les NPU des SoC actuels oscillent entre 40 et 50 TOPS, certaines cartes graphiques grand public dépassent de loin les 1000 TOPS, mais pour une consommation bien supérieure.

Il est en plus nécessaire d’avoir conscience de la précision de calcul de ces puces. Indiquée sous forme d’entiers et de bits, cette valeur représente un compromis entre vitesse et précision. Ainsi, INT4, la plus petite précision, peut s’avérer utile lors de tâches où la rapidité d’exécution prime.

La valeur INT8 est généralement plébiscitée par les constructeurs pour calculer la puissance brute d’un NPU, offrant une précision de calcul supérieure pour une vitesse de calcul suffisamment élevée pour nos usages, comme la reconnaissance d’images ainsi que les traitements photo / vidéo sommaires.

Généralement, les constructeurs raisonnent en INT8, car il s’agit d’une précision suffisante pour les usages grand public, mais les professionnels et scientifiques privilégieront des précisions en 16 et même 32 bits selon leurs besoins. Ces valeurs sont plus précises, mais autrement plus gourmandes en puissance brute.

Quelle utilisation dans nos machines ?

Pour les utilisateurs, il est question de latence et de sécurité. Certaines taches IA déportées sur le NPU sont traitées plus rapidement en local que sur le cloud, tout dépend de la robustesse de la puce. Ainsi, telle ou telle tâche fonctionnera mieux en local sur le NPU ou sur le cloud selon la charge de travail choisie.

Un NPU va vraiment décharger le travail du CPU et du GPU pour des tâches plus légères, comme la traduction en live, les sous-titres automatiques de Windows ou les effets de caméra qu’on voit désormais sur Microsoft Teams ou Google Meets. Microsoft assure que le NPU est 100x plus efficient sur Windows sur toutes ces tâches que le CPU, avec donc des gains d’autonomie à la clé.

Sur Windows, le NPU peut aussi servir à améliorer la performance de vos jeux grâce à la fonctionnalité d’upscaling AutoSR fonctionnant grâce à l’IA. Sur les Mac, le Neural Engine sera mis à contribution pour faire tourner Apple Intelligence, l’assistant IA d’Apple intégré dans toutes les facettes du système.

Nous n’en sommes qu’aux balbutiements de l’intelligence artificielle en local, si bien qu’une connexion internet reste nécessaire pour faire tourner une partie de ces fonctionnalités. Mais les NPU vont gagner en vitesse et en précision, ouvrant la porte à d’autres applications et usages pour améliorer la productivité et la créativité sur les ordinateurs portables. C’est en tout cas leur promesse.

Rendez-vous un mercredi sur deux sur Twitch, de 18h à 20h, pour suivre en direct l’émission SURVOLTÉS produite par Frandroid. Voiture électrique, vélo électrique, avis d’expert, jeux ou bien témoignages, il y en a pour tous les goûts !

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix