Voici quelques explications des termes techniques les plus courants qui devraient vous aider à y voir plus clair.

Un téléviseur est un appareil électronique de plus en plus complexe. En effet, au fil des années, les technologies d’affichage, mais également d’optimisation d’images s’enchainent à une vitesse effrénée pour des images toujours plus spectaculaires les unes que les autres. Le renouvellement d’un tel dispositif ne se prend pas à la légère, car souvent synonyme d’un certain investissement. Il n’intervient pas non plus tous les ans, à moins d’être un passionné souhaitant chaque année avoir le dernier cri.

Pour aller plus loin

Quels sont les meilleurs TV de 2026 ? Notre sélection

Aussi, il arrive que lorsque survient le moment de changer de téléviseur, les technologies aient tellement évolué qu’il est très facile de s’y perdre. Voici donc les principaux termes techniques utilisés dans les fiches de caractéristiques expliqués pour mieux vous y retrouver.

Les définitions, mettons les points sur les i

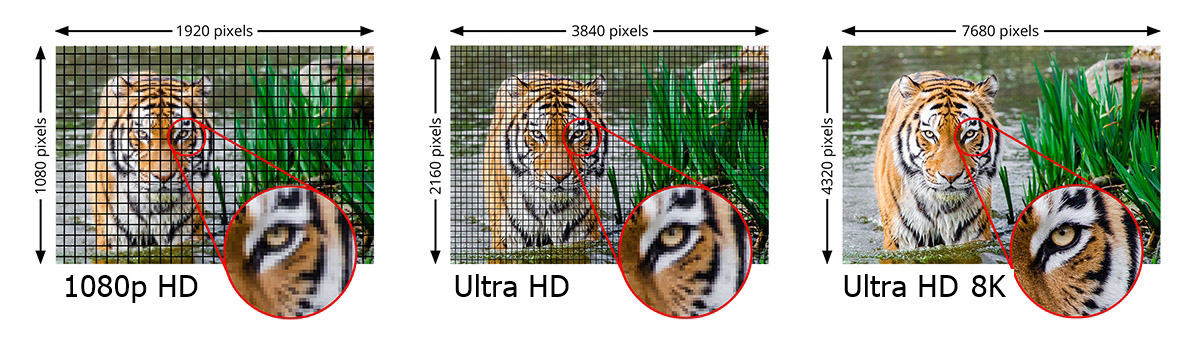

Commençons par des choses simples, à savoir la définition proposée par les différents téléviseurs actuellement sur le marché. Les entrées de gamme sont capables d’afficher une définition Full HD soit 1920 pixels en largeur et 1080 pixels en hauteur. D’autres, à partir du milieu de gamme jusqu’au haut de gamme, profitent d’une dalle capable d’afficher une définition Ultra HD.

Précisons qu’il s’agit bien du terme Ultra HD et non pas 4K. En effet, la définition Ultra HD (ou UHD) correspond à 3840 pixels de large pour 2160 pixels de haut avec un ratio de 16:9 correspondant aux cadres des téléviseurs. L’appellation 4K est associée à tort à l’Ultra HD puisqu’elle correspond à une définition de 4096 pixels de large pour 2160 pixels de haut, un format réservé à l’industrie du cinéma avec un ratio de 17:9. Concrètement, cela signifie qu’il n’existe pas de téléviseurs 4K, mais seulement des téléviseurs Ultra HD. Si vous voyez la mention 4K, c’est purement marketing, car il s’agit en réalité d’une définition Ultra HD.

Pour aller plus loin et tenter de s’approcher de la définition perceptible par l’œil humain, les fabricants ont réussi à développer des téléviseurs dotés de dalle ayant une définition Ultra HD 8K. Elle propose ainsi 7680 pixels de large pour 4320 pixels en hauteur, toujours au format 16:9.

HDR pour des scènes plus contrastées

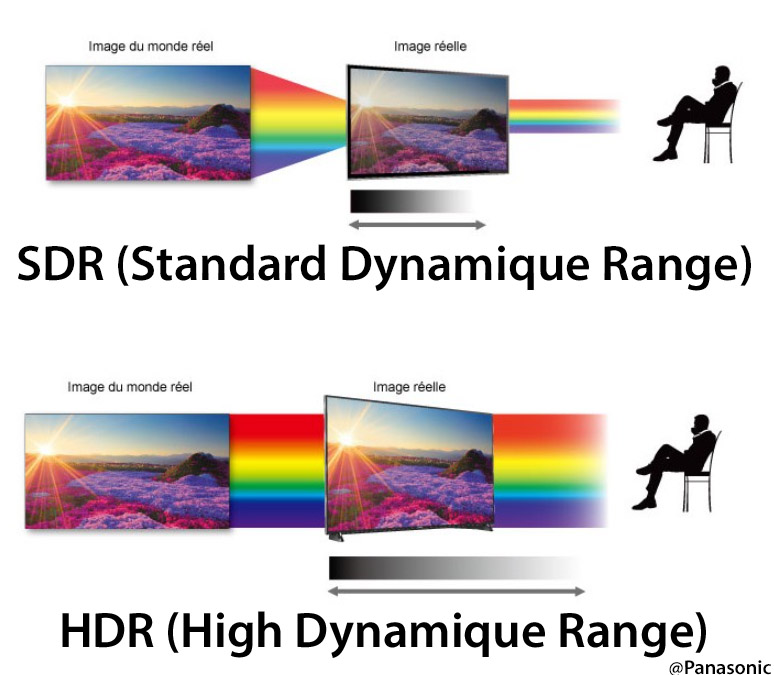

C’est le grand terme à la mode en ce moment. Un téléviseur peut être HDR (High Dynamic Range) ou non. Cette technologie signifie « large plage dynamique » en français et a pour principal but de mieux traduire à l’image la réalité de perception d’un œil humain surtout lorsqu’on lui présente une scène contrastée, c’est-à-dire comportant des zones très claires et d’autres plus sombres.

Globalement, il s’agit de renforcer le contraste, mais également les couleurs pour proposer des séquences les plus détaillées possible. La technologie HDR propose une plage dynamique plus large que la technologie SDR (Standard Dynamic Range ou plage dynamique standard) utilisée jusqu’ici.

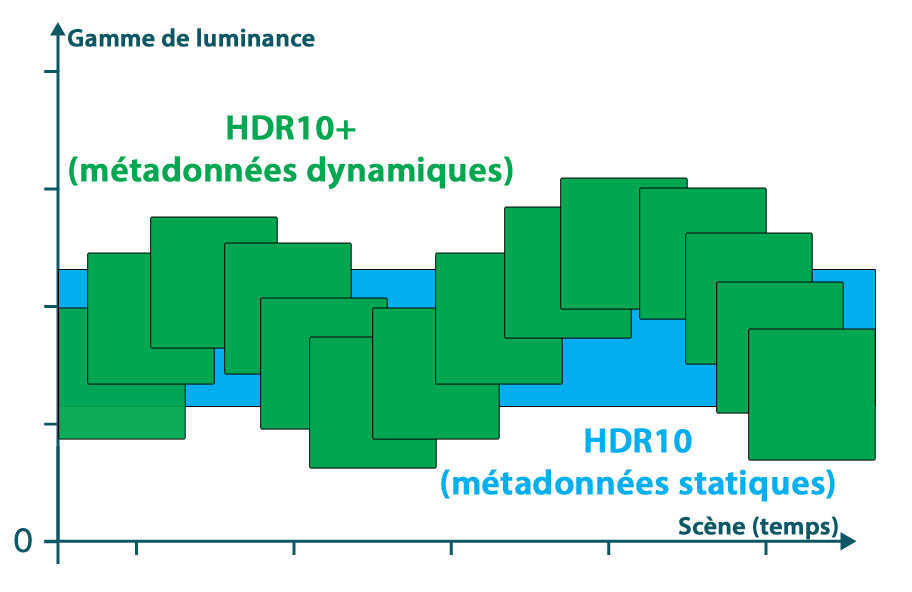

La mention HDR est le format court pour HDR10 qui est l’appellation officielle de cette technologie. Ensuite, il y a le HDR10+. Il s’agit d’une évolution de la technologie HDR10 qui prend en compte les variations de contraste au cours d’un film ou d’une série complète alors que le HDR10 applique un algorithme unique qui suit ce que l’on appelle les métadonnées ici statiques donc définitivement réglées pour la totalité du média lu. Le HDR10+ utilise les métadonnées dynamiques enregistrées séquence par séquence. Il s’agit d’informations qui régissent la reproduction optimale pour chaque scène.

Enfin, le format HDR10+ Adaptive reprend le principe d’utilisation des métadonnées dynamiques en y ajoutant une analyse de la luminosité ambiante dans la pièce grâce à la présence d’un capteur intégré dans le téléviseur. Ce dernier est alors capable d’ajuster automatiquement les réglages en fonction de la lumière qui règne dans la pièce. Concrètement, cela signifie que le téléviseur affichera une image plus lumineuse lorsque la pièce sera baignée de lumière et plus sombre lorsqu’elle sera dans l’obscurité.

Le format HDR10 (et ses déclinaisons) est dit « open source », permettant à toutes les entreprises qui veulent l’exploiter de l’en emparer sans payer de droit d’exploitation. Il est soutenu par plusieurs sociétés d’électronique grand public, dont Samsung, Panasonic, Philips, 20 th Century Fox, entre autres. Le format HDR10 et le HDR10+ peuvent afficher jusqu’à 1 milliard de couleurs grâce à une profondeur de 10 bits.

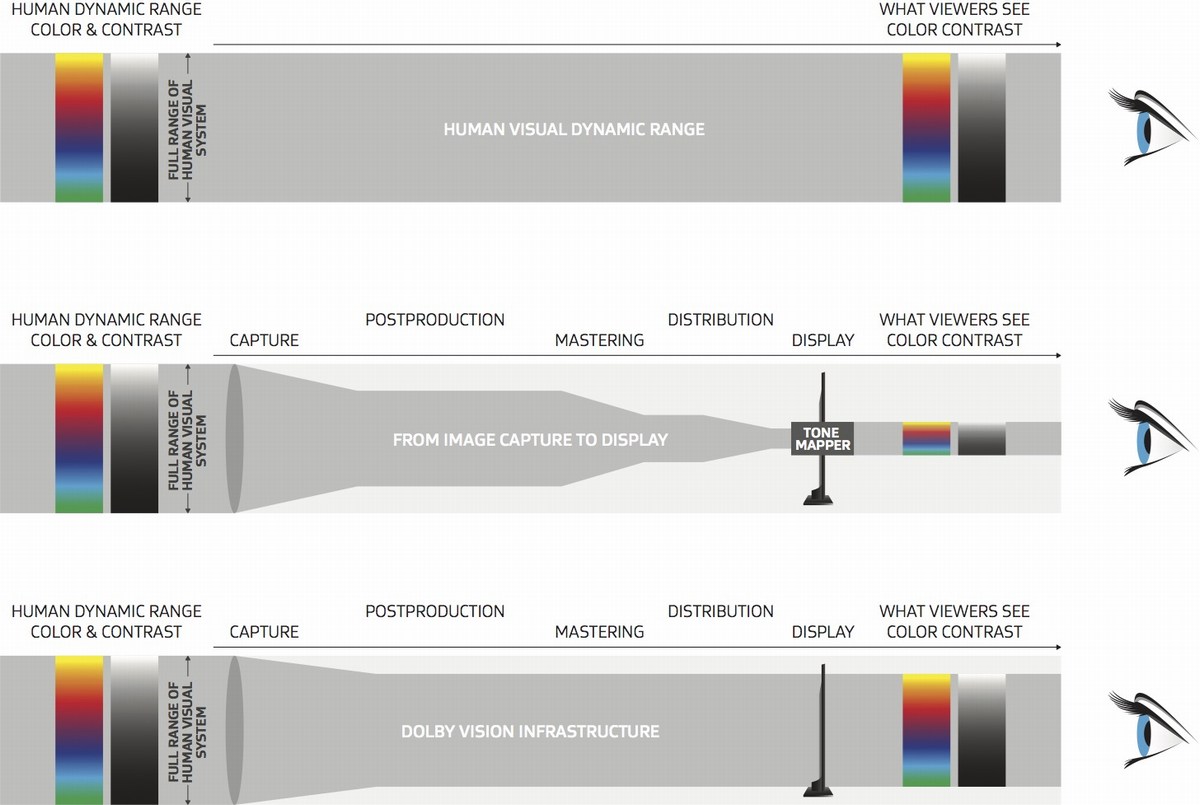

Dolby Vision, l’autre mode HDR

Très en vogue actuellement, la société américaine Dolby Laboratories a réussi à s’imposer comme une norme HDR utilisée par de très nombreux fabricants. Le format propriétaire Dolby Vision utilise, comme le concurrent HDR10+, les métadonnées pour signaler aux téléviseurs compatibles comment gérer dynamiquement les différentes scènes afin d’optimiser le rendu de la luminosité, le contraste et les couleurs. Le format Dolby Vision peut afficher en théorie jusqu’à 68,7 milliards de couleurs sur une profondeur de 12 bits, mais, à l’heure de l’écriture de ces lignes, il n’existe aucun téléviseur doté d’une dalle 12 bits.

La notion de Dolby Vision IQ est similaire au HDR10+ Adaptive. Il s’agit donc d’utiliser conjointement les métadonnées dynamiques et le niveau de luminosité ambiant pour régler les paramètres de l’image de manière optimale. Comme le HDR10+ Adaptive, il s’agit d’une option qui peut être désactivée dans les menus de la téléviseur.

8 bits + FRC, 10 bits, 12 bits, quézako ?

Sur un téléviseur, on parle beaucoup des couleurs. Intéressons-nous plus particulièrement à ce que l’on appelle la profondeur des couleurs. Pour bien comprendre, il faut faire appel à quelques notions d’informatique. En effet, un octet est composé de 8 bits et peut prendre des valeurs comprises entre 0 et 255 (entre 20 et 28). Pour les trois couleurs primaires, on a donc 256 nuances de rouge, 256 nuances de bleu et 256 nuances de vert soit un total de 16 millions de couleurs. Ca, c’est pour la théorie parce qu’en réalité, les contenus vidéo sont proposés avec seulement 220 nuances de chaque sous-pixel (de 16 à 235) et c’est ce que l’on appelle le RVB limité (Limited RGB) opposé au RVB Plein (Full RGB). La dalle d’un téléviseur 8 bits est donc capable d’afficher 16 millions de couleurs en théorie.

Pour aller plus loin, les industriels ont décidé de proposer un système sur 10 bits soit 1024 nuances de bleu, 1024 nuances de vert et 1024 nuances de rouge soit un total de 1 milliard de couleurs. La profondeur de couleurs 10 bits est donc plus importante qu’en 8 bits tout en gardant des couleurs maximales identiques.

Sur certaines dalles 8 bits, on peut apercevoir ce que l’on appelle un phénomène de color banding. Il s’agit d’un dégradé peu flatteur des couleurs lié à la faible quantification des niveaux de couleurs. Autrement, il n’y a pas assez de nuances entre les couleurs pour proposer un beau dégradé.

Pour pallier cela, les fabricants ont trouvé une parade. Ils utilisent une technologie appelée FRC (Frame Rate Control) qui consiste à améliorer la perception des couleurs affichées en extrapolant l’affichage de couleurs qui ne sont pas supportées nativement par la dalle. Cela limite les effets de color banding sur les dégradés et coûte moins cher qu’une dalle 10 bits. On parle alors de téléviseurs dotés d’une dalle 8 bits+FRC. Ils appartiennent la plupart du temps au segment de milieu de gamme. Les modèles haut de gamme privilégient les dalles 10 bits.

Comme évoqué plus haut, il n’existe pas actuellement de téléviseur grand public dotée d’une dalle 12 bits.

4:4:4, 4:2:2, 4:2:0, à quoi ça correspond ?

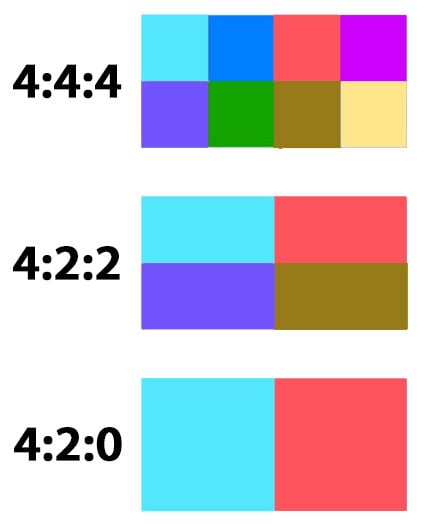

Pour définir une image, il y a beaucoup de notions telles que la profondeur de couleur en bits, le pic de luminosité ou le rapport de contraste. En outre, ce que l’on appelle l’échantillonnage de la chrominance permet de déterminer la fidélité de l’écran. Plus l’échantillonnage est important et plus l’image sera précise. Chaque pixel d’une image est reconstitué à partir des trois composants que sont la luminance Y, le chrominance bleue (Cb) et la chrominance rouge (Cr). Il est représenté sous la forme a:b:c.

Dans le cas d’un signal 4:4:4, celui-ci est totalement défini avec une gamme complète de couleurs avec un échantillonnage non compressé et représentant la meilleure qualité à ce jour. C’est aussi celui qui demande le plus grand débit vidéo. Si le signal est 4:2:2, cela signifie qu’il est compressé, ayant seulement 2 pixels échantillonnés (contre 4 précédemment) pour les deux lignes de couleur. Les autres sont dupliqués ce qui donne une moindre précision, mais permet toutefois de réduire significativement le débit nécessaire au transport de ce type de signal pour une perception finalement très proche. Enfin, dans le cas d’un signal 4:2:0, le débit est encore plus faible : environ deux fois moins que celui demandé pour un signal 4:4:4, mais seulement deux pixels ont des échantillons de couleurs, les autres étant des duplications.

Ainsi, privilégiez un modèle compatible 4:4:4 dans la mesure du possible ou au moins 4:2:2 pour de meilleurs résultats à l’image.

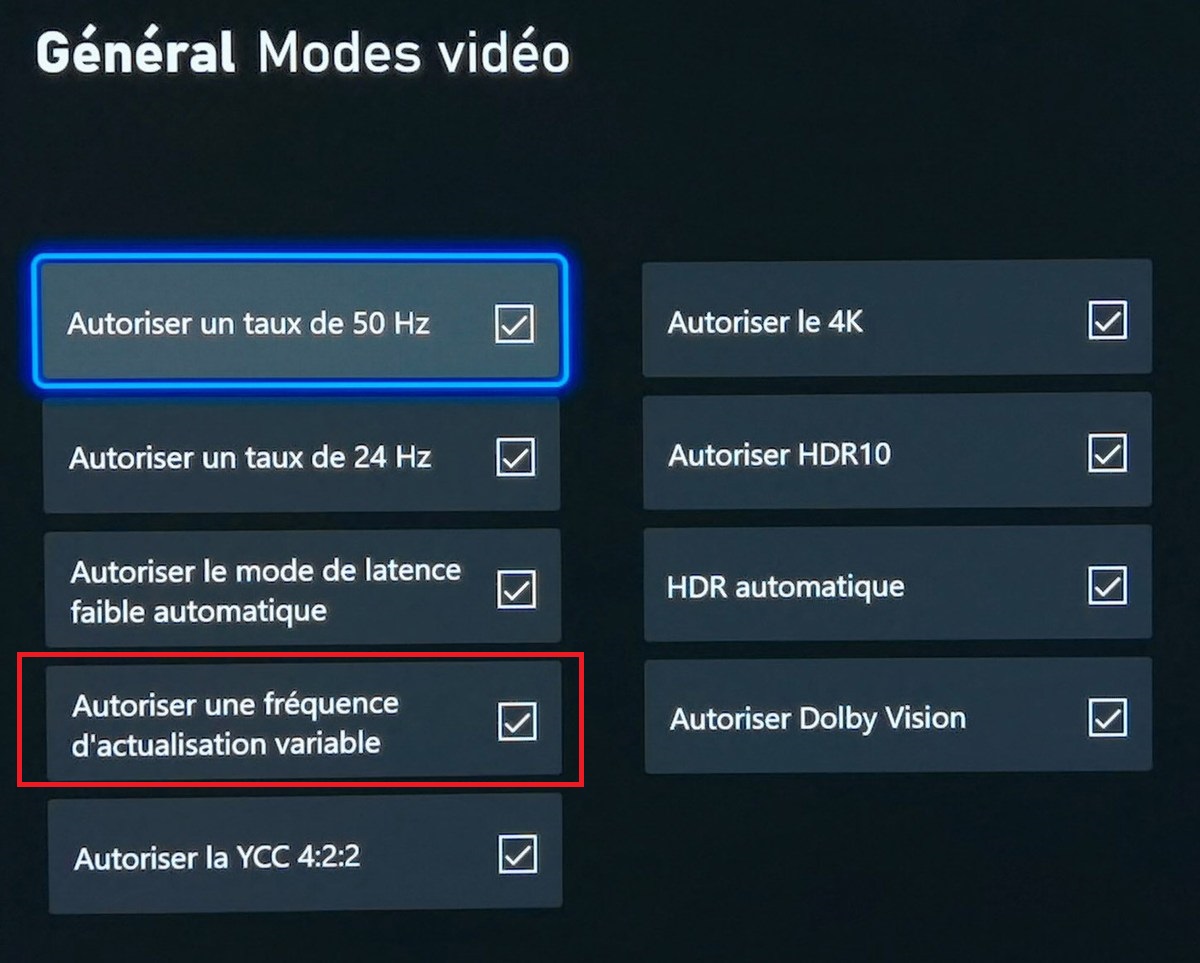

VRR : Variable Refresh Rate, pour les joueurs

La notion de VRR (Variable Refresh Rate) fait appel à une fonction d’un téléviseur qui lui permet de faire varier la fréquence de rafraîchissement de sa dalle pour tenter de la synchroniser avec la fréquence des images produites par la source, la plupart du temps, une console de jeux.

Cette option permet de limiter les déchirements d’image pouvant provenir d’une synchronisation hasardeuse entre la source et le diffuseur, en l’occurrence le téléviseur. Dans le cas de l’utilisation d’un ordinateur doté d’une carte graphique, on utilise pour cela les technologies développées par AMD et Nvidia, respectivement, FreeSync Premium (voire Premium Pro) et G-Sync. Il s’agit d’une fonction optionnelle de la norme HDMI 2.1.

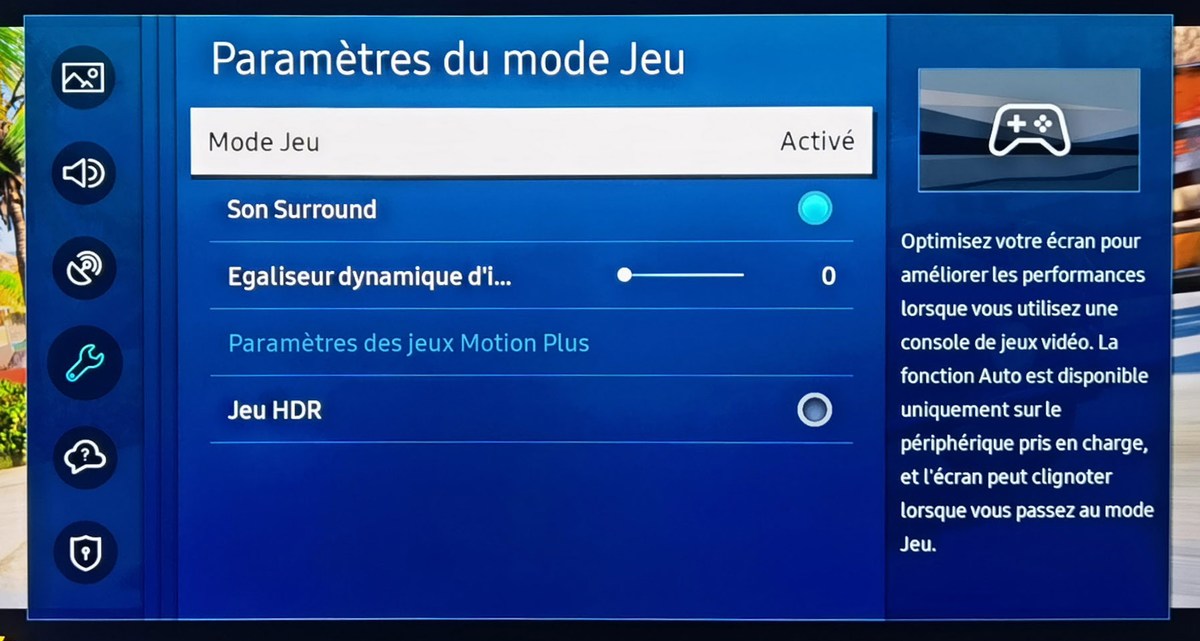

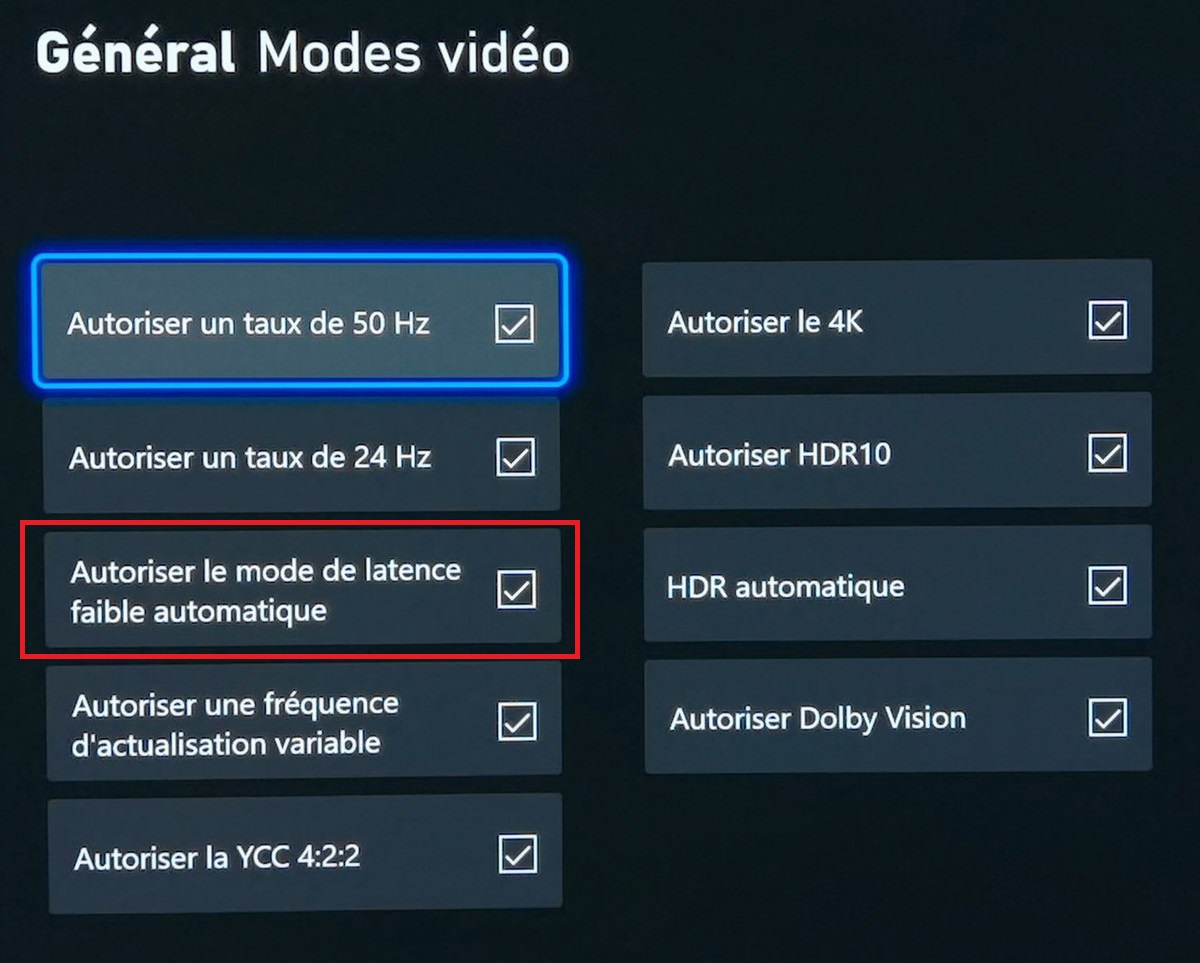

ALLM, pour réduire l’input lag

La fonction ALLM (Auto Low Latency Mode) permet à une source comme une console de jeux d’envoyer un signal au téléviseur via une liaison HDMI pour que celui-ci passe automatiquement dans un mode qui autorise un affichage plus rapide (le mode Jeu, typiquement).

Le téléviseur bascule ensuite dans un mode « normal » lorsque la fonction n’est plus nécessaire. Cette fonction permet donc de réduire ce que l’on appelle le retard à l’affichage ou input lag, correspondant au délai enregistré entre le moment où le joueur appuie sur le bouton de la manette de jeu et où l’action se déroule à l’écran. Il s’agit d’une fonction optionnelle de la norme HDMI 2.1, mais certains équipements de version HDMI antérieure peuvent aussi en profiter.

HDMI 2.1, quelles technologies sont compatibles ?

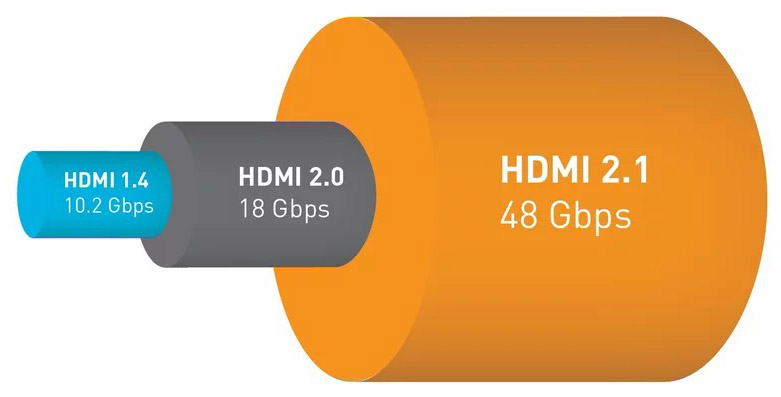

Évolution logique de l’interface HDMI, la version HDMI 2.1 englobe différentes fonctionnalités animées par une bande passante pouvant atteindre 48 Gbit/s.

Attention, le site du consortium HDMI précise que les équipements dotés d’une connectique HDMI compatible avec la version 2.1 ne supportent pas nécessairement l’intégralité des possibilités proposées par cette norme. Toutes les fonctions sont optionnelles. Pour des raisons marketing, les constructeurs peuvent jouer avec cette notion mettant ainsi en avant le numéro de version (2.1) dès lors qu’une fonctionnalité de la version en question est supportée, mais pas toutes, créant une certaine confusion.

Les fonctions supportées par la norme HDMI 2.1 sont les technologies HDR pour l’optimisation du contraste, VRR pour limiter les déchirements d’image dans les jeux, ALLM pour réduire le temps de retard à l’affichage ainsi que le QMS (Quick Media Switching) pour un basculement rapide d’une source à une autre, mais également le QFT (Quick Frame Transport) aidant à réduire le retard à l’affichage en abaissant le temps de transmission des images. La technologie eARC est également supportée, permettant ainsi de profiter d’un retour audio depuis le téléviseur vers un système audio via le port HDMI supportant les formats les plus exigeants.

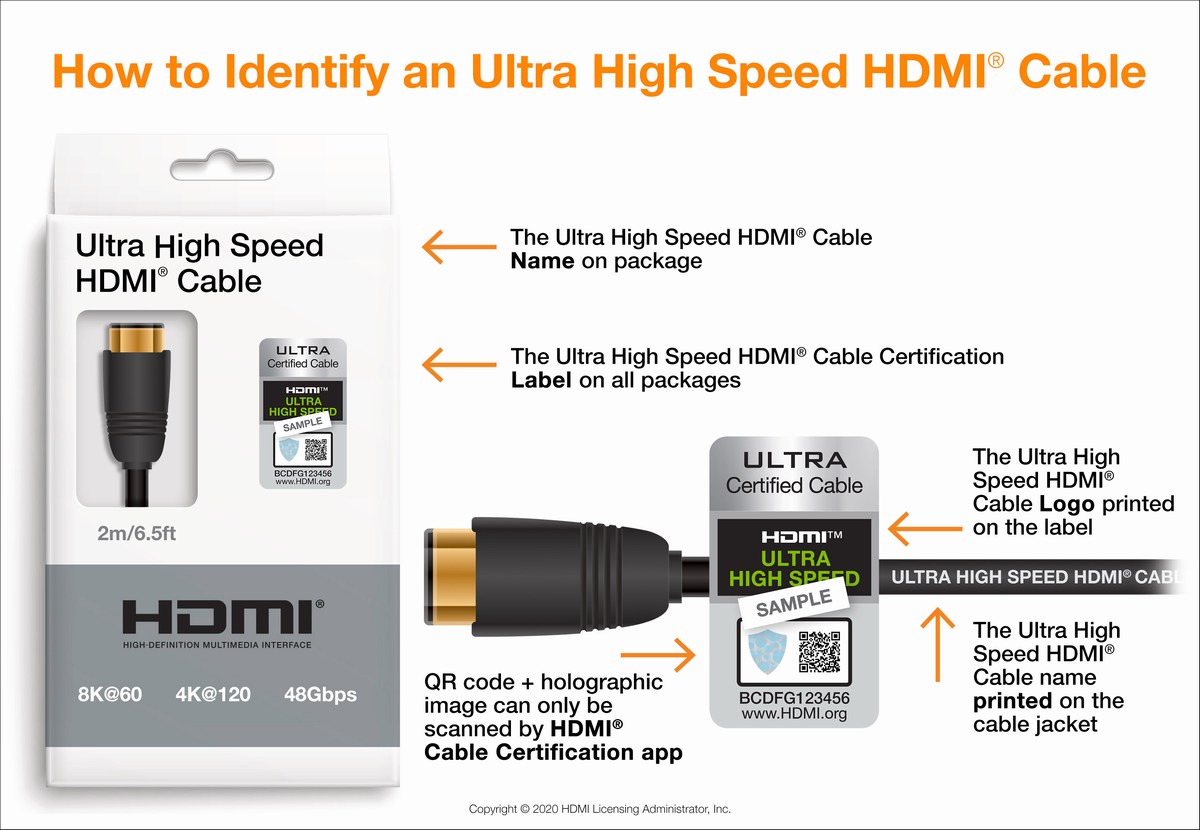

La norme HDMI 2.1 peut supporter les signaux vidéo Ultra HD jusqu’à 144 images par seconde et Ultra HD 8K à 60 images par seconde. Cela sous-entend que des définitions moindres sont bien entendu acceptées. Enfin, petite précision, mais cela va toujours mieux en le disant : il faut utiliser des câbles compatibles HDMI 2.1 pour profiter de toutes les technologies disponibles sur les appareils.

Chaque matin, WhatsApp s’anime avec les dernières nouvelles tech. Rejoignez notre canal Frandroid pour ne rien manquer !

Amusant qu'on essaie de faire passer le HDR 10+ pour le gentil et Dolby Vision relégué à "il fait comme le HDR 10+ mais payant", mais ça reste le Dolby Vision qui est utilisé par l'énorme majorité des studios de cinéma ou de télévision, on pourrait même dire que le HDR 10+ a disparu... Avec Disney qui a racheté la Fox, donc les futures productions seront en Dolby Vision puisque Disney n'utilise que de Dolby Vision sur Disney+ ou au cinéma avec le MCU et autres, donc il reste quoi comme studios qui vont utiliser et proposer du HDR 10+, la Fox était le seul studio nommé... Et sans troller, j'arrive pas à trouver les annonces pour les prochains contenus HDR 10+... Même Amazon Prime, ça fonctionne vraiment mal le HDR sur leur plateforme et très peu de contenus au final... Donc d'un côté on a Disney, Netflix, Apple, Paramount, Sony Pictures, etc. qui utilisent le Dolby Vision et pour le HDR 10+ à part des TV Samsung, quels sont les studios qui vont en proposer ? Merci :)

Merci

Correction : le Dolby Vision est ajouté au média lors du montage du film, donc les couleurs et contrastes affichés à l’écran reproduiront précisément le souhait du réalisateur car le mode Dolby (qui n’est pas de l’HDR) se calera précisément sur ça et ça permettra à 5 TV de 5 marques différentes d’afficher exactement le même rendu, là où l’HDR est fait différemment pour chaque constructeur à grands coups d’IA, de gestion de couleurs, de dalles différentes…. 5 TV différentes auront 5 rendus complètement différents en HDR et souvent trop saturé ou pas vraiment super.

heureusement que cela vient pas de ce site ! car coté improfessionel ils sont les rois ! Car ici se sont les spécialiste des fiches produits mais surtout de reprendre l'info sur d'autres sites ... Je pense en voyant la vidéo qu'ils ont été cherche le plus absurde des spécilaiste de cela cad PéPé ou le mec qui ne prends que des marque et qui ne regarde pas a la dépense ! mais surtout qui croit qu'il est bon parcequ'il est un vendu des marques mais bon ... encore un faux youtubeur ... et bientôt ils vont nous faire la même pour les pc et smartphone etc ...

Faire attention, un moniteur pouvant décoder un signal HDR ne signifie pas forcément qu'il est capable d'afficher le contenu comme il se doit... Très fréquent pour les écrans bas et milieu de gamme.

Vous dites que la 4k n'existe pas au niveau des télé, ce qui est vrai. Mais plus loin vous parlez de 8k ?

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix