MàJ : L’architecture quadruple-cœur Exynos 4412 sera bien dans le Galaxy S III :

« Already in production, the Exynos 4 Quad is scheduled to be adopted first into Samsung’s next Galaxy smartphone that will officially be announced in May » (source : Samsung)

Précédemment aperçu dans ces deux articles, le constructeur Samsung vient d’officialiser son nouveau fer de lance, l’Exynos 4 Quad.

Commercialement, il sera nommé Exynos 4 Quad avec pour nom de code Exynos 4412 qui signe la transition des architectures double vers quadruple-cœur du coréen dans ses terminaux mobiles haut de gamme. Même si nous n’avons encore pas mis la main sur la confirmation officielle, il est tout de même fort probable que ce nouveau SoC soit présent dans le futur Galaxy S III, et non un ancien SoC double-cœur qui ferait une certaine différence face à la concurrence.

Une architecture plus performante et économe, le SoC est toujours basé sur un ARM Cortex-A9 avec gravure plus fine en 32 nm, tandis que l’architecture double-cœur Exynos 4210 était gravée en 45 nm. Samsung avance une réduction de la consommation énergétique de l’ordre de 20% pour le SoC Exynos 4 Quad (gravé en 32 nm) contre le SoC Exynos 4 Dual (gravé en 45 nm), pour une architecture Exynos 4412 qui aura à l’initial une cadence de 1.4 GHz.

Pour améliorer l’efficacité énergétique, une fonctionnalité hot-plug a été adoptée, elle supporte la mise en marche/arrêt de chaque cœur, ainsi qu’un échelonnage dynamique du voltage et de la fréquence (DVFS) pour chaque cœur. Cela permet des réductions radicales de la consommation énergétique tout en adaptant les différents niveaux de voltage et de fréquence à la charge de travail.

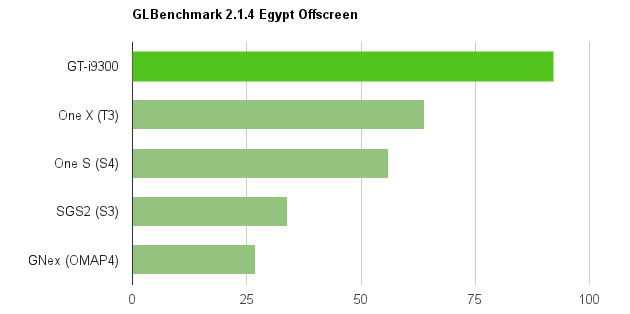

Si on se fie aux caractéristiques techniques du Meizu MX Quad-Core, l’architecture Exynos 4 Quad (Exynos 4412) intègre nativement une puce graphique Mali-400, mais avec une cadence pratiquement doublée face au Galaxy S II. Sur l’architecture Exynos 4 Dual, la puce graphique Mali-400 a une cadence maximale de l’ordre de 266 MHz. Sur la nouvelle architecture Exynos 4 Quad, elle aurait été poussée au delà de 400 MHz avec quatre cœurs à bord (nom Mali-400 MP4).

Plus d’informations dans cet article.

Je suis bien conscient que certains d’entre vous pensent que l’Exynos 4 Quad embarque la nouvelle puce graphique Mali-T604, mais jusqu’à preuve officielle du contraire il s’agit d’une Mali-400 (comme il a été constaté dans le Meizu X Quad-Core). En outre, comme vous vous en doutez déjà l’architecture Exynos 4 Quad (Exynos 4412) supportera nativement de manière matériel la lecture et l’enregistrement de vidéo en Full HD 1080p à 30 images par seconde.

Ci-dessous, découvrez une vidéo de démonstration des performances de l’architecture :

https://youtube.com/watch?v=ndtvyTPIx3Q%3Frel%3D0

Dans celle-ci, on peut y apercevoir plusieurs comparaisons, notamment entre les architectures Exynos 4210 (gravée en 45 nm) et Exynos 4212 (gravée en 32 nm).

.. et Reymss pour ses précisions. ;)

Tous nos bons plans directement sur WhatsApp. Rejoignez Frandroid Bons Plans, zéro spam garanti.

Que Meizu est un GPU 400 ne signifie pas grand chose. Je doute que Samsung ai decidė de mettre leurs nouveaux fleurons niveau SoC chez un concurrent au lieu de l'intégrer dans leur flagship (S3).

Ca c'est le benchmark qui est ou non optimisé pour le multi-core. Android fourni ce qu'il faut pour exploiter les coeurs.

Au risque de te décevoir fortement, les Cowon comme le J3 sont basés sur des SoC Telechips .. Et devine un peut quel est le codec audio mis avec en général ? http://www.styleflying.com/styleflying/upload/fckeditor/File/TCC8900_PMP_Promotion_V1.4.pdf Bah mince alors, un Wolfson WM8988, sachant que dans le SGS premier du nom on a un WM8994et dans le SGS2 un Yamaha bien moins bon ce dernier, il n'y a qu'a voir les différents tests qui avec RMAA par exemple.Donc tu disais ?

Reste à voir si c'est vrai ou pas. Si non quand est-ce qu'ils vont ce décidé pour réduire la consomation conséquente de toutes ces puissance? Je veux bien parler toujours du meilleur Smartphone en puissance, mais parlons aussi en meme temps du meilleur en autonomie!

Ah ok, très bien, je suis d'accord avec toi dans ce cas là. :) Il est sur que HTC pers un argument en ne mettant plus des Beats dans la boîte, car même un pékin lambda ou presque connaît la marque.

Je ne pense pas avoir dit que popularité = qualité (la preuve: Apple et ses iPhones :P) mais que la qualité Beats est meilleur que celle qu'on trouve sur la plupart des Androphone. Le but principale d'un smartphone (pour la firme qui le conçoit) c'est de se vendre, encore une fois, Apple, je ne pense pas que la plupart des utilisateurs des iPhones l'utilisent pour autre chose que de téléphoner et envoyer des messages.Moi même je préfère les casques de Sony ou de AKG :PN’empêche que c'est de Beats qui se vendent mieux! Ce n'est pas toujours la meilleur qualité qui gagne :(Pour revenir à l’essentiel:Oui la qualité Beats est meilleur que celle qu'il y a de base chez HTC!Je ne vois pas pourquoi quelqu'un de "normale" refuserait un tel plus sur son téléphone. C'est un argument de vente assez lourd!

c'est quoi le telephone dans la vidéo 0:53 ??

Moi ce que je veux surtout savoir c'est si le GPU est de nouvelle génération. Si c'est juste un GPU de Galaxy S2 avec une montée de la fréquence, je prefère attendre une custom Rom avec un kernel basé sur le S3 et l'installer sur mon S2. En attendant une meilleur surprise avec la Galaxy Note 2! Arretez avec vos quadcore et boostez vos GPU, vendez nous du rêve, des jeux aux graphismes de console next gen plutot que des CPU multicore qui servent quasiment à rien pour les jeux! Celà me rappel la course aux gros processeurs sur PC alors qu'en réalité une bonne grosse carte graphique fait toute la difference!

c'est un peu chiant aussi de devoir se coltiner deux trucs donc bon avec une puce son de bonne facture ce serait déjà pas mal et pas juste un equalizer comme ce que fait htc avec beats audio

^^

Popularité = qualité?! Ouch. Leurs écouteurs ne se vendent que grâce à leur image de marque. Leur qualité sonore est plus que discutable. Il suffit de s'intéresser un minimum et de lire les différents tests pour le voir. Néanmoins les goûts les couleurs, mais dire que l'ont prend un Beats pour la qualité c'est ridicule, c'est juste pour l'image.

en fait vous dites dans la news des caracteristiques qu'il sagit bien du 4212 mais vous l'annoncez comme un double coeur... vous devriez modifier la news de 00.05 du jeudi 26

"Par contre, utilisez un super jeu 3D : sur le single core, il tourne pas, donc pas de question. Sur le dual, il tourne avec sacade ou sinon il faut descendre en graphismes." Tu est sur de la connerie que tu dit ?

ce que je comprends pas c'est que deux news plus tot vous dites qu'enfin vous avez les caracteristiques du SGIII et que c'est un double coeur...

C'est mieux que rien et apres c'est ton gout... la popularité de leur casques en est une preuve ;)

Beats, qualité sonore... ------>[]

Il faut arrêter de se masturber sur le nombre de core , Intel ont sorti un téléphone MONO core et il est quasiment égal avec le HTC one X ! Depuis 3 ans c'est la même architecture ( A9) sur laquelle on rajoute des core , mais l'architecture est dépassé. Il n'y a pas d'innovation. Regardez les benchmark du processeur mobile intel : http://www.anandtech.com/show/5770/lava-xolo-x900-review-the-first-intel-medfield-phone/4

En théorie oui mais android n'est pas (encore) fait pour fonctionner comme ca . La preuve c'est que le processeur mobile intel atom testé sur Anandtech a des benchmark quasi-égaux avec ceux du HTC one X. 1 core = 4 core.....et oui.

Prends un Sony (n'importe le quel) et je t'assure que Walkman a ajouté sa touche et pour les nouveaux HTC c'est pareil avec Beats. Apres c'est sur que la qualité n’égalera jamais un Cowon mais pour une personne "normale" (pas un melomaniac :P) ca conviens largement. C'est ce que fait Apple, les iPods ont une qualité sonore assez moyenne, mais pour un telephone c'est deja excellent.

En théorie il le surpasse sur tout les points. Et surtout sur l'autonomie, grâce à sa finesse de gravure (32nm contre 45nm)

Nous verrons bien si cette technologie sera embarqué dans le prochain téléphone de Samsung le Galaxy S3 !

On parlent souvent de la course à la puissance, mais pourquoi pas aux fps d'enregistrement vidéo ? Ridicule de mettre 30fps à 1080p quand les professionnels de la vidéo utilisent eux 24-25fps qui donne une image plus cinématique, c'est ce que je voudrais sur un phone. Sinon il est bien quad core et graphiquement aussi.

J'attends la comparaison avec le Tegra 3 sur touts les points (perf, autonomie, ...)

D'ailleurs quand tu changes de modem, ca change l'indice DAS ?

3j sur un Milestone, j'aimerai voir ça :/ Peut être qu'avec la bonne rom et un undervoltage, mais c'est tellement lent que ça deviens limite inutilisable (je précise que je tourne encore dessus)

Hum... je rappelle quand même que le GPU de la Vita est un monstre qui est énorme et qui consomme beaucoup trop. L'ipad 3 qui possède un SGX543MP4 a déjà un SoC qui fait plus de 2 fois la surface des Exynos. Le SoC de la Vita possède 4 coeurs CPU et un SGX543MP4+ (donc qui monte plus haut en fréquence), beaucoup trop gros et consommateur pour un téléphone (même une fois passé en 32nm)

bon alors dual ou quad parce que la je suis completement perdu dans l'article on parle des deux comme s'ils etaient la meme chose

oui enfin HTC a sciemment mis une petite batterie, officiellement annoncé qu'il ont misé sur la finesse en lieu et place de l'autonomie... Y a rien à ajouter à ça ...

en même tps c'est pas sur un smartphone que tu auras du bon son ... :/ prends toi un cowon ou iriver =)

Comme tu le dis, on parle CPU et GPU, parfois de la puce audio. Ok Il faut aussi signaler que les galaxy ont un DAS tres bas.

Sauf que cette logique n'est pas forcément vrai. L'OS va plutôt avoir tendance a utiliser un proc au maximum plutôt que de partager plusieurs taches. Un processeur n'est pas égale à une application. Au contraire, le proc se fait tellement chier en général, qu'il peut traiter 4 applications simple à la suite et donc faire du "temps réel". De plus quelque soit la fréquence d'un coeur, il y a des éléments qui sont forcément alimentés et consomme du courant quelque soit la fréquence.

" Moi le seul gâchis que je vois pour le moment, c'est un HTC One X qui est parfait, mais avec une autonomie dérisoire pour un surcroît de puissance que la grande majorité des utilisateurs n'utiliseront pas (moi y compris)." Le One X a surtout une Rom moisie, très mal optimisé. "Il faut parfois sortir le nez du guidon des benchs et autre course à la puissance. Tout le monde ne veut pas un téléphone plus puissant qu'une Playstation 3." Le rôle des Galaxy S.. c'est d'être les modèles haut de gamme de Samsung, tout le monde n'a pas besoin d'une telle puissance, mais c'est pour ça il y a des smartphone moyens et entrée de gamme. Au prix que sera vendu le S3 on est en droit d'attendre des performances hors normes.

True.

c'est des note sur la première photo !!

+1 Samsung ne va quand même pas fournir un quad core a Meizu et garder un double coeur pour son modèle phare.

Faut espérer voodoo pour Gs3 ...

L'Exynos 3110 single-core était basé sur un GPU PowerVR SGX540, mais depuis ils ont signé avec Mali.

Sauf si : - le mono coeur est gravé nettement plus fin : dans ce cas il est plus rapide, il chauffe moins et consomme moins => gain intéressant ; - ils ont fait d'autres optimisations autour du CPU pour la conso et mis une meilleure batterie (en 1 an, il doit y avoir qq progrès de ce coté, même mineurs)

Effectivement, les multicores sur mobile c'est assez récent. J'attends pas mal d'optimisation de la part de Google dans Jelly Bean à ce sujet. Aussi, la partie "pure 3D" devrait être portée par le GPU. C'est pas pour rien que sur iphone -- il me semble qu' -- ils ont un mono coeur sans trop de puissance et un GPU survitaminé ...

Dans ce cas, prends toi un vieux motorola milestone, son autonomie est de presque 3jours en utilisation normale. Si t'es si malin, va faire de la recherche pour avoir une source d'énergie fiable et utilisable quotidiennement pour les smartphones. Car penser que les constructeurs ne planchent pas sur ce problème, c'est limite quand même... Prenons le cas d'Apple par exemple, ils ont presque doublé la capacité de la batterie de leur nouvel ipad pour avoir au final une autonomie semblable à l'ipad 2...

j'aurais aimé voir le même gpu que sur la vita étant donné que c'est samsung qui confectionne le cpu de cette dernière dommage

De toute évidence, c'est la même chose pour quoi que ce soit. Faut arrêter de cracher sur l'autonomie par rapport à la puissance. Un ordinateur portable, c'est exactement pareil. Quand on fait du traitement de texte, ça consomme rien, par contre quand on commence de lancer des jeux, ou des films, bah le niveau de charge diminue plus vite.Dans un autre domaine, on peut avoir une voiture de 240 chevaux et rouler pèpère, on consommera peu, mais quand on a besoin de toute la puissance, bah on suce le carburant.L'autonomie d'une batterie, c'est toujours indicatif, et varie toujours en fonction des besoins de l'utilisateur. Sur mon GNote, la semaine quand je bosse je peux faire 2 voir 3 jours sans recharger, et le week end je le recharge tous les soirs. Donc moi l'autonomie, au final ça m'importe peu puisque ça varie en fonction de mes besoins et que ça change chaque jour. Par contre, le quad core est réellement utile pour les jeux 3D comme tu dis, mais ça serait pas mal que certaines applications les utilisent correctement (par exemple un navigateur internet qui consomme pas mal)

a voir, grosse deception dans le cas contraire nous reservir du double coeur non merci et qu'il augmente la taille de la batterie un peu

C'est vrai que l'on parle toujours des CPU, puis des GPU ... mais jamais du son. Je découvre grâce à ton commentaire ce genre de "régression". Pour moi, à quelques exception marketing près, tous étaient plus ou moins pareil (et plutôt mauvais).

Et ajoutons une info : si on a 4 traitements + ou - faible en CPU en parallèle par ex : - mise à jour d'un flux par le lecteur RSS en tache de fond ; - lecture mp3 ; - lecture d'un document ; - récupération d'un email ... alors le quad core peut tirer profit de ses 4 coeurs tournant à 100Mhz. Un dual core verra sa fréquence augmenter fortement, genre 2 coeurs à 400 Mhz (voire plus). Un single core sera au max. Niveau conso, si un coeur à 100Mhz c'est 100 unités, un coeur à 200Mhz c'est nettement plus que 200 unités (peut être 400 ?). Donc il est préférable dans ce cas d'avoir plus de coeurs. Par contre, utilisez un super jeu 3D : sur le single core, il tourne pas, donc pas de question. Sur le dual, il tourne avec sacade ou sinon il faut descendre en graphismes. Sur le quad il tourne superbien ... mais les 4 coeurs ssont à fond et la batterie le voit bien ! Donc un quad, c'est plus économe pour la vie de tous les jours, mais quand il faut toute la puissance, vous en aurez, mais aurez besoin de plus de batterie

«Une architecture plus ambidextre»? Il est aussi habile de chaque cœur?

A mon avis c'est Antutu qui a mal reconnu le 4412 et a affiché un 4212 ... m'enfin bon ...

Donc pas de "breakthrough" quoi... d'abords le SGS3 s'annonce en dual alors que tout le monde l'attendait en quad, maintenant ca. Espérons qu'ils se rattrapent sur l'autonomie.

Si ! Ca serait du gâchi, je m'explique :Avoir 4 coeurs ne signifie pas qu'ils faut tous les utiliser/alimenter. On peut avoir 4 coeur et n'en utiliser que deux 95% du temps. Mais quand on a besoin de vitesse, alors là on utilise les quatre !De plus concernant l'autonomie, sur mon SII, le plus gros consommateur, c'est pas le CPU, c'est l'écran... donc à finesse de gravure égale par rapport à un dual, un quad core aurait une consommation supérieure presque négligeable.

Ce n'est pas "il est fort probable" mais officiel que le Galaxy S3 aura ce processeur quad ;-)

"il est tout de même fort probable que ce nouveau SoC soit présent dans le futur Galaxy S3, et non un ancien SoC double-cœur qui serait un réel gâchis, surtout face à la concurrence." Moi le seul gâchis que je vois pour le moment, c'est un HTC One X qui est parfait, mais avec une autonomie dérisoire pour un surcroît de puissance que la grande majorité des utilisateurs n'utiliseront pas (moi y compris). Il faut parfois sortir le nez du guidon des benchs et autre course à la puissance. Tout le monde ne veut pas un téléphone plus puissant qu'une Playstation 3.

C'était écrit dans le deuxième paragraphe "4212" au lieu de "4210".

Bonnes performances, l’écran est tout de même plus grand que le s2 donc la batterie sera améliorée. Niveau autonomie ca devrait être pareil que le S2, réponse le 3 mai.

Le 4212 est en double-coeur, il a juste une meilleure gravure 32 nm vs 45 nm sur le 4210. Là où ça grimpe en coeurs, c'est avec le 4412 qui passe en quad vs 4212 en double.

Je savais pas qu'un overclock permettait d’augmenter le nombre de coeurs???

J'attends d'avoir des informations sur la partie GPU et surtout Son, parce que mon SGS1 avec la puce Wolfson écrase celle du GS2. Need du bon bon son...

Ca ne serait pas un gachis d'utiliser un dual core dans un GS3. Un quad core peut consommer plus. Dans une tablette, on peut mettre une grosse batterie et la consommation peut donc être augmentée sans vraiment réduire l'autonomie. Dans un portable, la taille est vraiment très limitée, le moindre gain est bon à prendre. Je ne dis pas que Samsung n'utilisera pas ou ne doit pas utiliser son quadcore dans le GS3, juste que ce choix dépend essentiellement de la consommation réelle du SoC en utilisation quotidienne et qu'il faut faire attention à ne pas tomber dans le piège de la course aux GFlops. Nokia a montré avec ses Lumia qu'un processeur relativement lent peut tout à fait convenir pour un smartphone haut de gamme. Là ou ils se sont plantés, c'est sur le point de l'autonomie de leur téléphone qui n'était pas si exceptionnelle.

Je crois que je vais arrêtez de lire les rumeurs car depuis quelque jours, on se fait bien baiser. Heu, juste, le 4212 est gravé en 32nm. C'est un overclock du 4210 du SGSII. Comparé le a lui plutôt qu'a l'exynos 4212.

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix