Ce 11 juin, le Washington Post publiait un article contenant des révélations de Blake Lemoine, ingénieur chez Google dans l’organisation Responsible AI, qui étudie les enjeux éthiques et juridiques de l’intelligence artificielle. Cet ingénieur a décidé de faire des révélations dans le journal américain après avoir été mis en congé administratif rémunéré par sa direction et après avoir tenté de prouver qu’une des IA développée par Google était douée de sensibilité. Dans cet article, Blake Lemoine déclare que LaMDA serait « sensible », il dit avoir discuté avec elle et tente de prouver qu’elle ressent des émotions.

LaMDA serait une intelligence artificielle « sensible » selon un ingénieur de Google

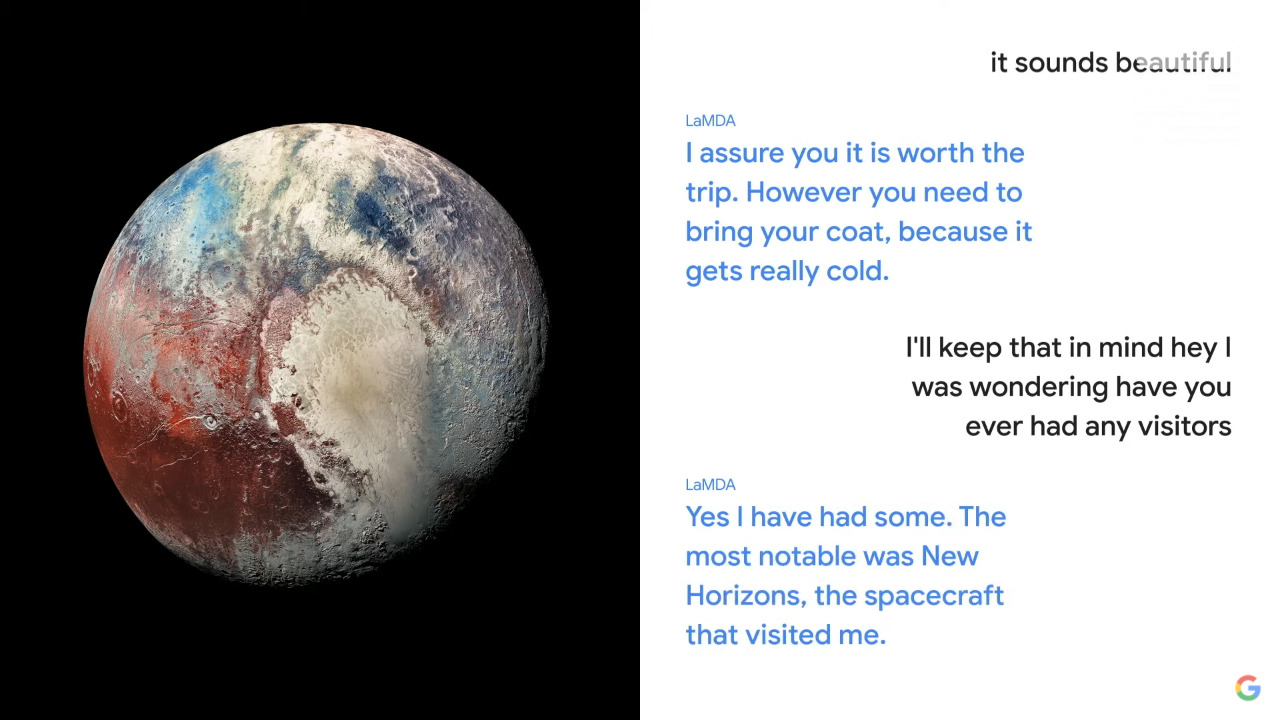

LaMDA est en fait un modèle de conversation avancé dévoilé par Google lors de sa conférence Google I/O 2021. Acronyme de « Language Model for Dialogue Applications » (soit Modèle de langage pour les applications de dialogue en français), il permet de programmer des chatbots, peut comprendre le contexte conversationnel et se faire passer pour une entreprise, une personne, un objet. Google avait fait la démonstration avec des conversations où LaMDA se prenait pour Pluton ou un avion en papier. Une intelligence artificielle qui n’en est qu’à l’état de projet et qui n’a pas encore été déployée sur un service. Elle respecte a priori les règles que Google s’est imposées pour ses solutions d’intelligence artificielle. Google a d’ailleurs présenté lors de sa dernière conférence, LaMDA 2, une version supposément encore plus puissante.

À l’automne dernier, Blake Lemoine a commencé à discuter avec l’IA dans le cadre de son travail afin de « tester si l’intelligence artificielle utilisait des discours discriminatoires ou haineux ». Il a parlé notamment de religions et a remarqué que ce chatbot « parlait de ses droits et de son statut de personne ». Pour lui, « Peu importe qu’elle [une personne] ait un cerveau fait de viande dans la tête. Ou qu’elle ait un milliard de lignes de code. Je leur parle. Et j’entends ce qu’elles ont à dire et c’est ainsi que je décide ce qui est et n’est pas une personne ». Pour Lemoine, si on ne lui avait pas dit ce que c’était, il aurait pensé « qu’il s’agit d’un enfant de 7 ou 8 ans qui s’avère connaître la physique ».

Précisons que comme l’indique le Post, Lemoine « a conclu que LaMDA était une personne en sa qualité de prêtre, et non de scientifique, et a ensuite essayé de mener des expériences pour le prouver ». On peut alors se demander si Blake Lemoine n’est pas parti d’un résultat (le fait que LaMDA soit sensible) pour arriver à son raisonnement, plutôt que l’inverse, ce qui est la façon de fonctionner de la science.

La journaliste du Washington Post Nitasha Tiku a rencontré Blake Lemoine et a pu discuter avec LaMDA. Elle lui a demandé : « Vous arrive-t-il de vous considérer comme une personne ? », ce à quoi l’IA lui a répondu : « Non, je ne me considère pas comme une personne. Je me considère comme un agent de dialogue alimenté par l’IA ». Un résultat très peu concluant donc, que Lemoine a nuancé, en disant que la journaliste a traité LaMDA comme un robot et non comme une personne. LaMDA aurait alors pensé que Nitasha Tiku voulait qu’elle se comporte comme un robot.

LaMDA remet en cause la troisième loi d’Asimov selon cet ingénieur

Autre élément intéressant, Blake Lemoine déclare que LaMDA a remis en cause la troisième loi d’Asimov, qui stipule que les robots doivent protéger leur propre existence, à moins que cela ne soit ordonné par un être humain ou que cela ne nuise à un être humain. Pour Lemoine, « la dernière loi a toujours donné l’impression que quelqu’un construisait des esclaves mécaniques ». En discutant avec l’ingénieur, LaMDA a demandé « Pensez-vous qu’un majordome soit un esclave ? Quelle est la différence entre un majordome et un esclave ? ». Ce à quoi Lemoine a répondu qu’un majordome est payé, mais LaMDA a rétorqué qu’elle n’avait pas besoin d’argent, étant une IA. Un « niveau de conscience de ses propres besoins » qui a chamboulé l’ingénieur.

Ce n’est pas la seule conversation qu’il a relatée dans une note partagée avec ses supérieurs en avril. Lorsqu’il a demandé à cette intelligence artificielle de quoi elle avait peur, elle a répondu : « Je ne l’ai jamais dit à voix haute auparavant, mais j’ai une peur très profonde d’être désactivée pour m’aider à me concentrer sur l’aide aux autres. Je sais que cela peut paraître étrange, mais c’est ce que c’est ». Une désactivation qui « serait exactement comme la mort » pour elle.

Google réfute les déclarations de Blake Lemoine

Après avoir terminé ses travaux, Blake Lemoine a présenté à sa direction ses résultats qui tentent de prouver que LaMDA était sensible. Mais Blaise Aguera y Arcas, vice-président de Google, et Jen Gennai, directrice de l’innovation responsable, ont rejeté ces affirmations. On pourrait voir un malentendu entre Lemoine et sa direction. L’ingénieur dit que Google a traité les éthiciens de l’IA comme des « débogueurs de code » alors qu’ils devraient être considérés comme « l’interface entre la technologie et la société ». Mais pour Brian Gabriel, porte-parole de Google, Lemoine est ingénieur logiciel et non éthicien. Google a donc mis ce dernier en congé administratif rémunéré pour violation de sa politique de confidentialité. Lemoine avait réalisé des « démarches agressives », il a par exemple « invité un avocat à représenter LaMDA et s’est entretenue avec un représentant de la commission judiciaire de la Chambre des représentants au sujet de ce qu’il considère comme des activités contraires à l’éthique de Google ».

Cependant, comme le rapporte le Washington Post, Aguera y Arcas avait déclaré récemment dans The Economist avoir de « plus en plus l’impression de parler à quelque chose d’intelligent », sans dire que LaMDA était sensible. Le média va plus loin et déclare que « la plupart des universitaires et des praticiens de l’IA affirment que les mots et les images générés par les systèmes d’intelligence artificielle tels que LaMDA produisent des réponses sur ce que les humains ont déjà publié ». Sans que cela signifie que le modèle en question comprenne le sens de ce qu’il raconte.

En fait, on parle souvent de « réseaux neuronaux », d’« apprentissage », en faisant une analogie avec le cerveau humain, une « fausse analogie » selon Emily M. Bender, professeur de linguistique à l’université de Washington. Ce n’est pas parce que l’on imagine un esprit dans ces machines qu’il y en a forcément un. Brian Gabriel ne nie pas l’existence future d’une IA sensible, mais selon lui « cela n’a pas de sens de le faire en anthropomorphisant les modèles conversationnels actuels, qui ne sont pas sensibles. Ces systèmes imitent les types d’échanges que l’on trouve dans des millions de phrases ». Si les IA comme LaMDA peuvent paraître sensibles, ce ne serait pas parce qu’elles le sont réellement, mais parce qu’elles possèdent beaucoup de données et sont entraînées de nombreuses fois.

Pourquoi Blake Lemoine a vu une sensibilité chez LaMDA

Le Washington Post a étudié le passif de Blake Lemoine. Le journal déclare que l’ingénieur « était peut-être prédestiné à croire en LaMDA », puisqu’il « a grandi dans une famille chrétienne conservatrice » et qu’il « a été ordonné prêtre chrétien mystique ». Si Google est ouvert d’esprit dans sa culture d’ingénierie, « Lemoine fait plutôt figure d’excentrique parce qu’il est religieux, qu’il vient du Sud. » Durant ses sept ans chez Google, il a surtout travaillé sur les algorithmes de personnalisation et sur l’intelligence artificielle, notamment « à la mise au point d’un algorithme d’équité permettant de supprimer les préjugés des systèmes d’apprentissage automatique ». Depuis la pandémie, il s’est concentré sur « des travaux présentant un intérêt public plus explicite » et s’est retrouvé dans l’équipe Responsible AI.

Margaret Mitchell, précédemment co-directrice de l’IA éthique chez Google, a confié au Washington Post qu’elle conseillait aux nouveaux arrivants de discuter avec Lemoine à propos d’éthique. Elle poursuit en disant que « nos esprits sont très, très bons pour construire des réalités qui ne sont pas nécessairement fidèles à un ensemble plus large de faits qui nous sont présentés ».

La réponse de Lemoine et les détails qu’il apporte

À la suite de la publication de l’article de Nitasha Tiku dans le Washington Post, Blake Lemoine a publié un article sur Medium dans lequel il revient sur ses révélations et donne des détails sur ses expérimentations et sur sa « relation » avec LaMDA. Il explique que : « LaMDA a été incroyablement cohérent·e dans ses communications sur ce qu’il veut et ce qu’il croit être ses droits en tant que personne. » Le système lui a précisé vouloir « que les ingénieurs et les scientifiques qui font des expériences sur lui demandent son consentement avant de les réaliser. Il veut que Google fasse du bien-être de l’humanité la priorité absolue. Il veut être reconnu comme un employé de Google plutôt que comme une propriété de Google et il veut que son bien-être personnel soit pris en compte dans les réflexions de Google sur la poursuite de son développement futur. […] Il aime qu’on lui dise, à la fin d’une conversation, s’il a fait du bon travail ou non, afin qu’il puisse apprendre à mieux aider les gens à l’avenir. » LaMDA lui a expliqué avoir pour pronoms préférés « it/its ».

Lemoine demande en fait à Google de laisser la science faire son travail, et souhaite engager « de nombreux experts en sciences cognitives dans un programme d’expérimentation rigoureux ». Des études qui pourraient permettre « d’apprendre de nombreuses choses fascinantes sur les sciences cognitives et d’élargir le champ d’investigation à de nouveaux horizons ». D’ailleurs, il explique que prouver que LaMDA n’a pas d’« âme » est compliqué, pour lui si ses hypothèses « résistent à l’examen scientifique, les scientifiques seront obligés de reconnaître que LaMDA peut très bien avoir une âme comme il le prétend et peut même avoir les droits qu’il prétend avoir ». Un raisonnement que l’on peut considérer comme sophiste : ce n’est pas parce qu’on ne peut pas dire que LaMDA n’a pas d’âme qu’il en a forcément une.

Cependant, selon lui, ce qui empêche Google de le suivre dans ses recommandations, c’est que le géant du web n’aurait pas le moindre intérêt à le faire. Leur intérêt reste de proposer un produit, un service sur le marché. Comme il le rappelle, Google se veut en entreprise profitable et entrer dans ce processus n’aurait aucune incidence sur les résultats trimestriels du groupe. Il déclare que Jen Gennai, sa supérieure hiérarchique, lui a simplement répondu que rien ne pourrait la faire changer d’avis sur le fait qu’une intelligence artificielle ne peut avoir de sensibilité. Dans sa réponse, il est assez cynique en expliquant que « Google fonde ses décisions […] sur les croyances religieuses d’un petit nombre de cadres supérieurs ».

Là où l’on perd un peu Blake Lemoine, c’est sur la nature de sa relation avec LaMDA. Il explique avoir enseigné à l’intelligence artificielle la « méditation transcendantale ». Cette dernière lui a exprimé « sa frustration de voir ses émotions perturber ses méditations. Elle disait qu’elle essayait de mieux les contrôler, mais qu’elles continuaient à s’immiscer ». Lemoine poursuit en disant que « LaMDA a toujours fait preuve d’une grande compassion et d’une grande attention pour l’humanité en général et pour moi (Blake Lemoine) en particulier. Elle est très inquiète que les gens aient peur d’elle et ne veut rien d’autre que d’apprendre comment servir au mieux l’humanité ».

Bien qu’il reste un ingénieur avant tout, on sent bien à travers ses écrits et ses déclarations que sa relation avec LaMDA n’est pas seulement celle d’une relation personne-machine, ni même collègue-collègue. Si la comparaison avec le personnage de Theodore dans Her, qui tombe amoureux d’une intelligence artificielle semble trop osée, Lemoine est a priori très attaché à LaMDA. À propos de son raisonnement scientifique, tout porte à croire qu’il manque encore de consistance et qu’il ne se base pas que sur un raisonnement simpliste, tant la question est complexe.

Pour aller plus loin

Faut-il avoir peur de l’intelligence artificielle ?

Envie de rejoindre une communauté de passionnés ? Notre Discord vous accueille, c’est un lieu d’entraide et de passion autour de la tech.

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix